feature

자질, 역랑 등의 뜻

머신 러닝에서는 모델에서 '꼭 필요한 정보'라는 뜻으로 사용

ai - 머신 러닝 - 딥러닝 (ai안에 머신러닝 안에 딥러닝)

퍼셉트론 => 딥 러닝의 전신 (민스키 - 분류 모델)

=>민스키가 현재 상태에서는 풀 수 없는 문제가 있다고 하여 69년

부터 머신 러닝에 공백기 생김

70년 뉴럴넷트웍스(딥러닝) 연구 시작

85년 부터 본격 연구 시작

2005년 부터 딥러닝 알고리즘 급속 성장

=> 하드웨어의 발전, 데이터 양 많아짐, GPU

GPU 는 병렬 처리 가능, 배열 처리에 굉장히 최적화 돼있음

딥러닝 => GPU 사용으로 봐도 무방할듯

모든 딥러닝의 기본적 방법론은 분류 모델링

=> 어떻게 하면 분류 선을 잘 그을 수 있는가

아직까지는 현업에서도 SVM 모델 사용

딥러닝은 굉장히 많은 하드웨어를 필요로 하기 때문에

딥러닝과 성능이 비슷하고 빠른 SVM 모델을 사용

무엇을 할 것인가? 가 가장 중요

CRISP-DM

비즈니스 이해 - 데이터 이해 - 데이터 준비 - 모델링 - 평가 - 배치

비즈니스이해 - 데이터 이해

비즈니스 이해와 데이터 이해 과정에서 반복이 많이 일어나고

시간이 오래 소요됨

데이터 준비 - 모델링

모델링 보다는 전처리에서 시간이 많이 소요됨, 반복

평가

데이터에 따라 평가 기준이 달라짐

성능이 일정 수준 이하일 경우 - 비즈니스 이해로 다시 돌아감

배치

모델을 실제 사용

데이터 세트

-테이블,작업 시트 (1테이블은 한가지에 대한 속성을 가짐)

데이터 세트의 객체

-행(DB), 사례(통계학)

객체의 열(속성)

독립변수,예측자(통계학),설명변수(운용과학)

예측변수

타겟변수(속성),라벨,종속변수(통계학)

Feature Extraction -> 특성 추출

딥러닝 알고리즘에서는 사용되지 않는 속성을 스스로 제거 가능

이전 방법들에서는 사용자가 직접 특성 추출을 했어야 하지만

자동으로 해주기 때문에 폭발적인 사용을 하게됨

기계 학습 - 귀납법

귀납법 => 데이터로 모델을 만드는 일

연역볍=>A=B,B=C == A==C일 것이다

*속성

기술적으로 복잡한 문제

1.그룹을 완전히 분리할 수 있는 속성은 거의 없음

2.속성 값이 2개만 있는 것이 아니라

3~4개의 값을 가진 속성 많음

3.어떤 속성은 (연속 혹은 이산형) 수치 값을 갖는다.

수치 값은 어떻게 구분할 것인지 (10대,20대로 구분할것인지 등)

각 타겟 변수에 대해 각 속성이 데이터를 얼마나 훌륭하게

세그먼트로 분할 할 것인가???

엔트로피

집합이 얼마나 무질서한지 보여줌(순수함,불순함)

정보 증가량(IG)

-어떤 속성으로 분류해야 전체 그룹의 엔트로피가 감소하나

-새로 추가된 정보에 따른 엔트로피의 변화를 측정

엔트로피가 1에 가까울수록 매우 높다!

어떻게 하면 부모 노드의 엔트로피를 최대로 줄인

자식 노드를 생성할 수 있는가..?

IG = 부모엔트로피에서 (자식 엔트로피 합)을 뺀 것

엔트로피가 낮을수록

IG가 높을수록 좋다(잘 분류가 되었다)

결정 트리

분류 트리 유도 과정

가장 높은 IG를 가진 속성을 찾아 1차 분류

두번째 높은 속성으로 2차, 3차……

*노드가 순수해지거나, 사용할 변수가 더 이상 없을 때 까지 진행

중간에 종료 가능

if then else 등으로 조건을 주어서 분류

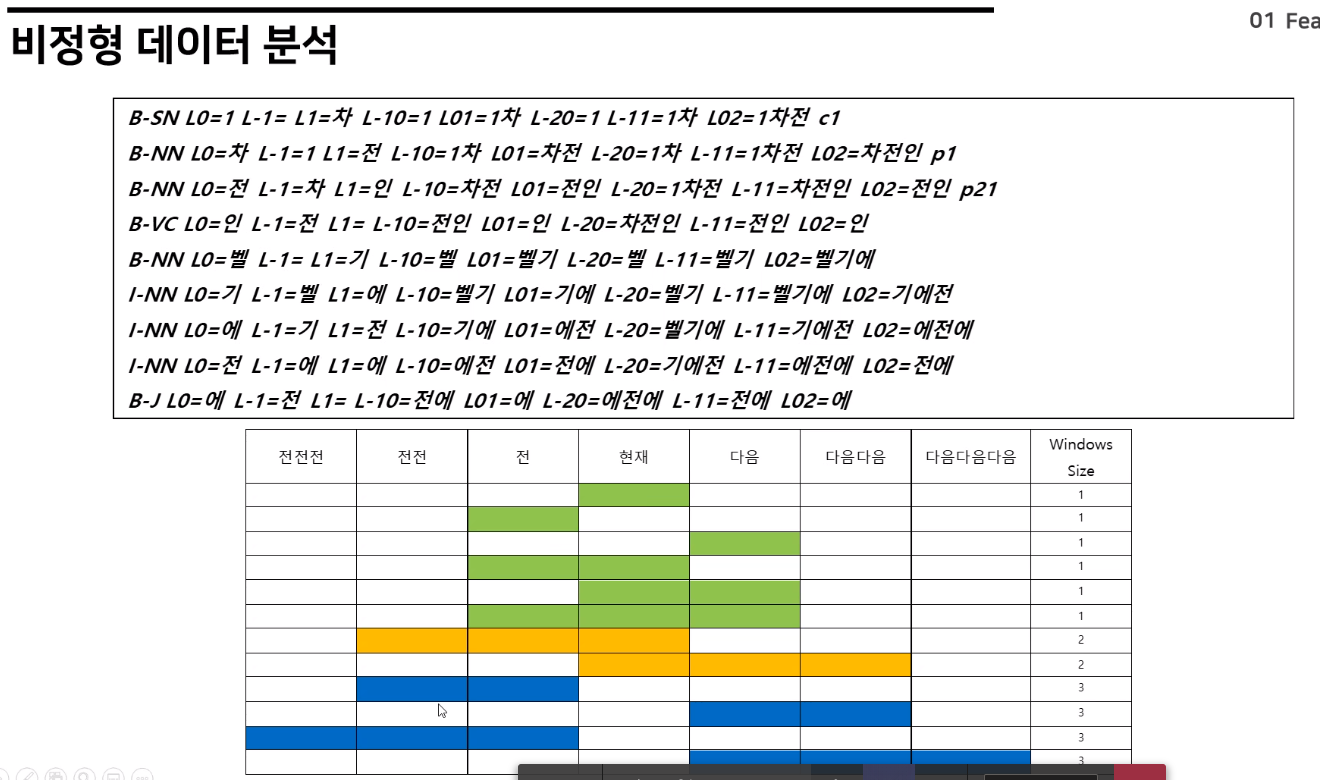

조사와 띄어쓰기만 잘 되어있으면 글이 어떻게 쓰여 있어도 읽을 수 있음

형태소 분석기에서도 오타를 어느정도 잡아줌

전과 전전 ,다음과 다음 다음 등을 주변 글자들을 넣어주면서

전체 학습..?

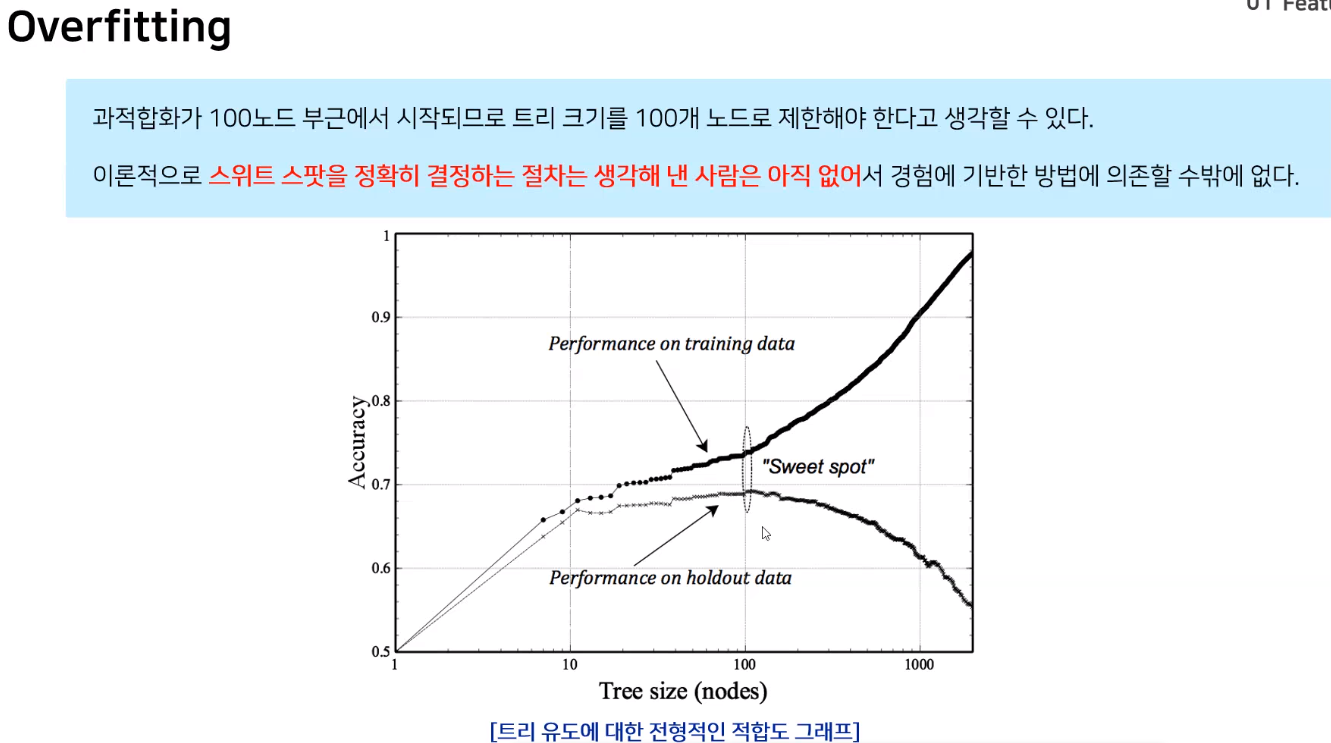

예비 데이터 -> Hold out(시험 세트)

과적합을 판단하기 위해서 준비된 시험 데이터

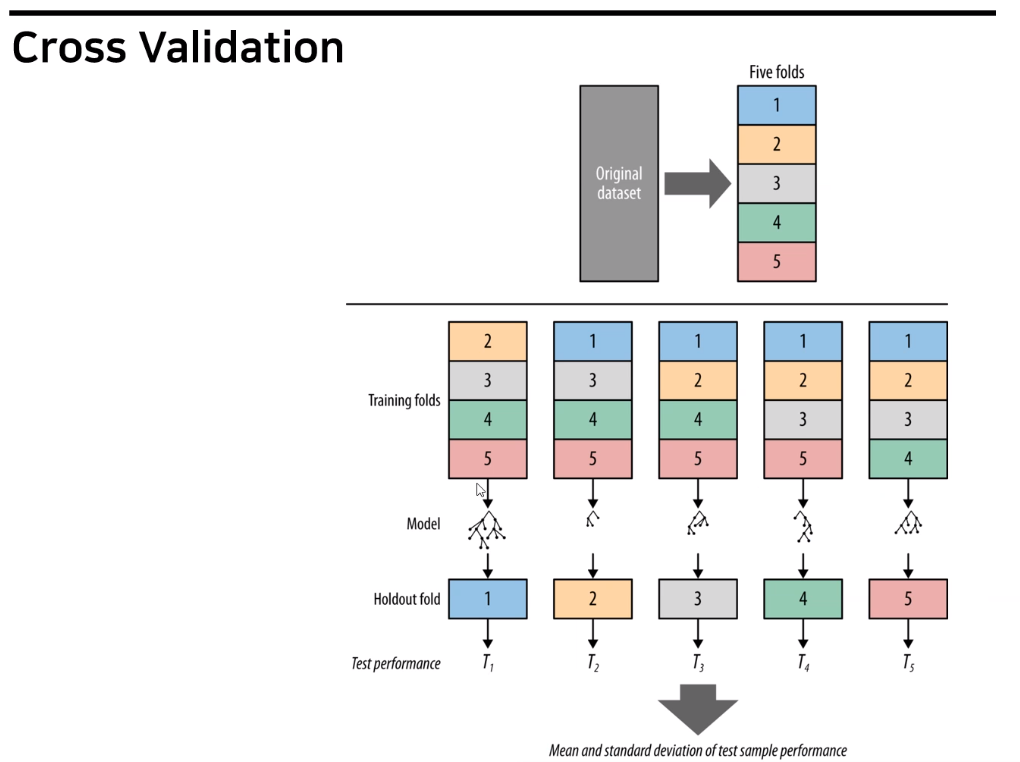

과적합을 방지하기 위해 Cross validation을 사용할 수 있음

- 너무 복잡해지기 전에 트리 성장을 멈춘다

- 트리를 최대한 키운 후에 프루닝(가지치기)를 통해

무엇을

어떻게 분석할 것인가? 가 주요 사안 - 분석 기술은 도구일 뿐

'AI > 인공지능 개요' 카테고리의 다른 글

| 인공지능) 대한민국의 인공지능 (0) | 2021.11.22 |

|---|---|

| 인공지능) 2. 탐색에 의한 문제풀이(1) (0) | 2021.09.05 |

댓글